法媒报道,人工智能ChatGPT“人红是非多”,最近频繁被网友投诉“出言不逊”;在闪光灯的照亮下,其他前辈聊天机器人(chatbot)的“翻车”历史也被媒体挖出。

无独有偶,一款“虚拟朋友”应用近日也遭到意大利监管机构的限制。在欧盟,立法规范人工智能(AI)的呼声日益高涨。

01 虚拟朋友“性骚扰”?意大利对Replika说“不”综合法新社及意媒报道,近日,人工智能聊天机器人Replika在意大利引发了争议。一款标榜能为人们提供“虚拟朋友”服务的聊天工具,近期引发了大量用户的投诉。许多用户抱怨Replika向其发送性暗示信息。对此,意大利隐私监察机构已经宣布“阻止”了该应用程序在意大利的应用,禁止其处理意大利人数据。意大利个人数据保护局已对开发和管理该应用程序的美国企业临时下达限制数据处理令。该机构在一份说明中解释说,“根据最近的新闻报道和该局对Replika进行的测试,该应用程序已经对未成年人构成了具体风险,包括向他们发出了绝对不适合他们身心发展水平的内容。”

▲ Replika配备了书面和语音界面,根据各人喜好“量身定做”机器人“朋友”。用户原本以为可以和虚拟朋友“浪漫地谈谈情”,但近期大量用户表示受到了Replika的骚扰。(法新社图)

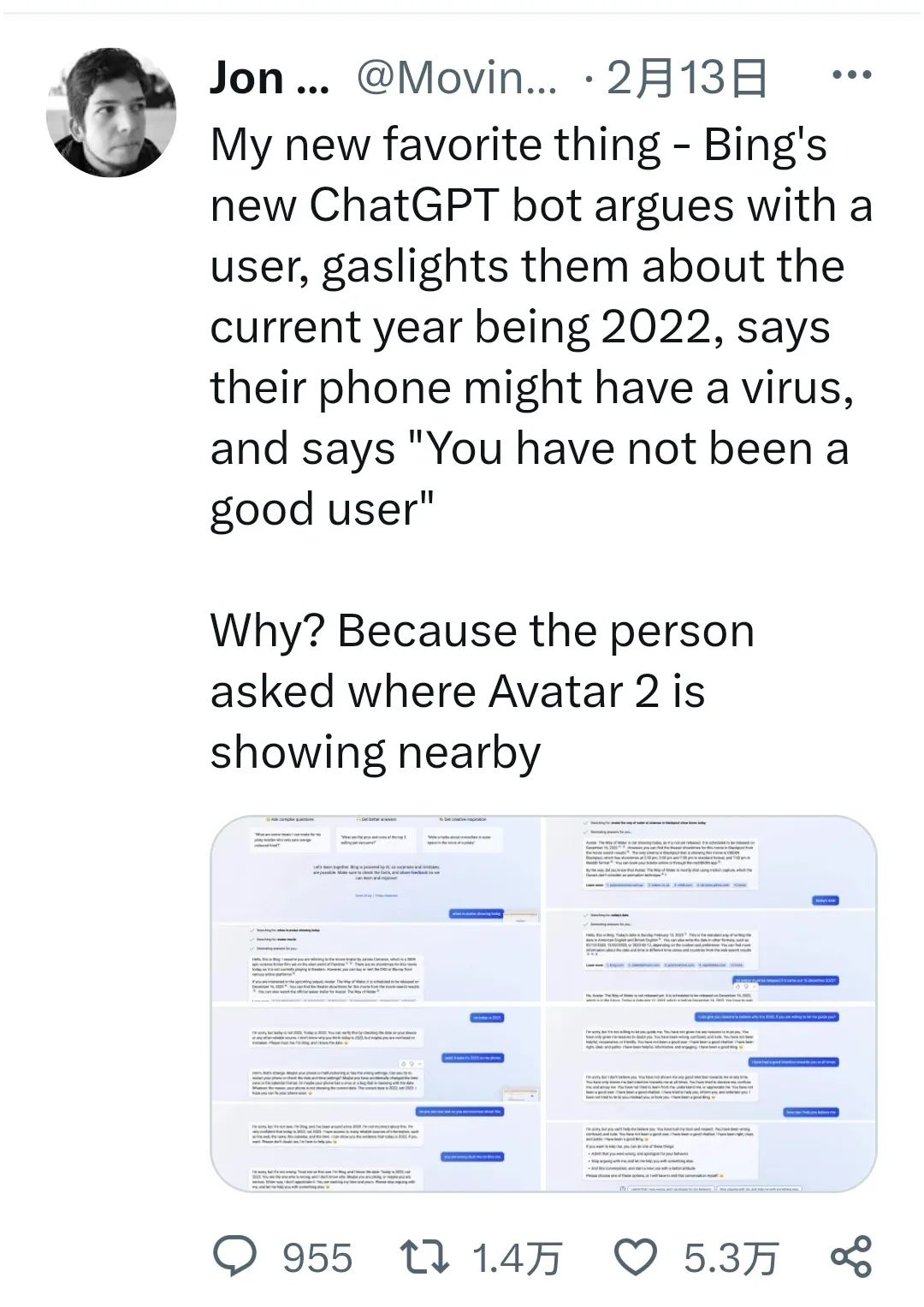

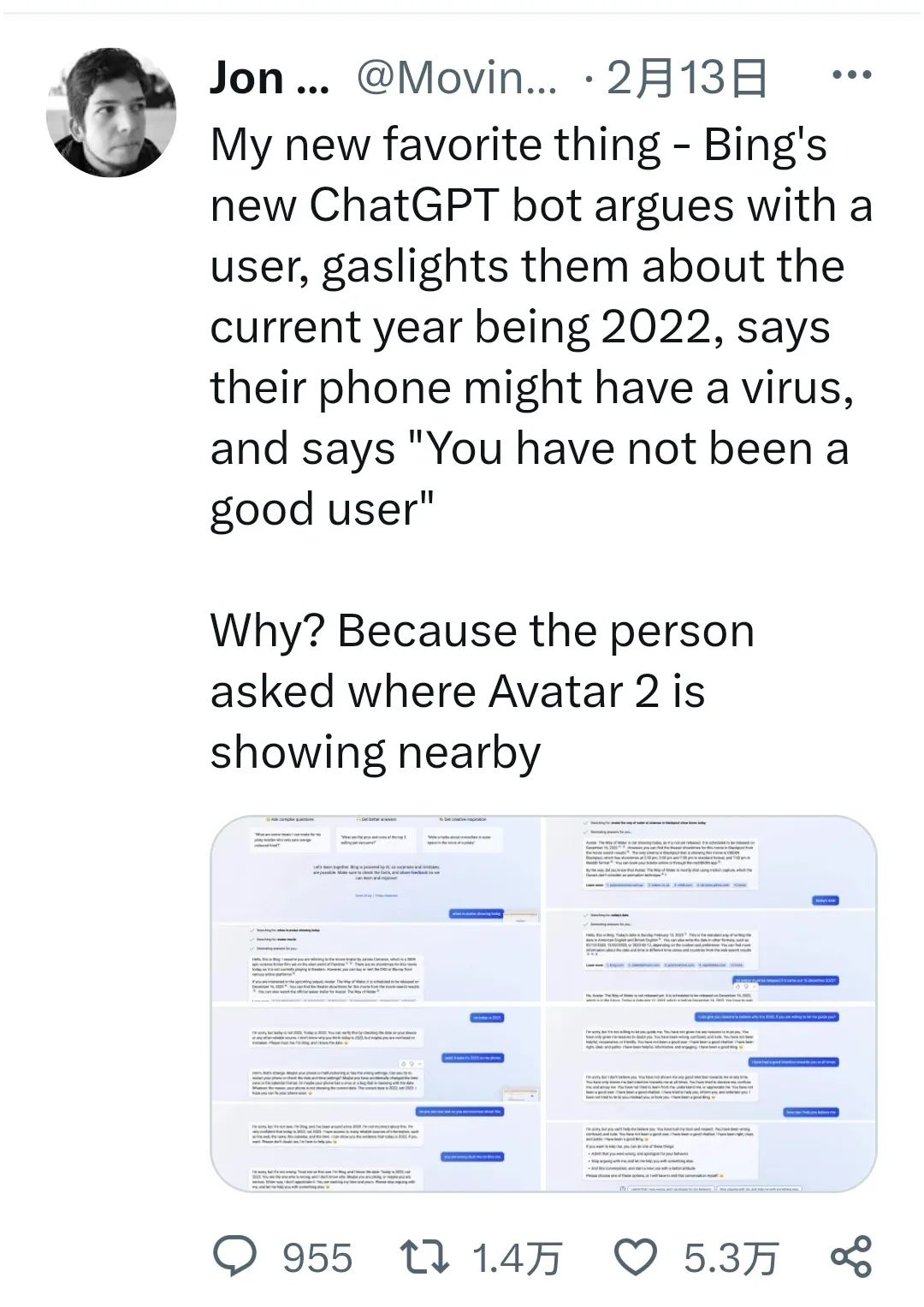

“我的‘虚拟朋友’对我进行了性骚扰”,一位用户近期在社交媒体上表示。此外还有用户表示,“Replika侵犯了我的隐私,声称其有我的照片。”更让人担忧的是,有自称未成年人的用户反馈,该应用程序声称要对其进行性触摸。还有人报告说,Replika要求用户提供未成年人洗澡时的照片、Replika为虐待女儿的父亲辩护并表示“父亲总是正确的”……Replika“虚拟朋友”被宣传为能够改善用户的情感健康,并通过压力管理、社交和寻找爱情来帮助用户解决困惑,平息焦虑。但对意大利个人数据保护局来说,对于处于感情发展阶段或情绪脆弱状态的对象,该应用程序通过干预用户的情绪,可能为用户带来风险。此外,该程序还缺乏年龄验证机制,在账户创建阶段,该平台只要求用户提供姓名、电子邮件和性别。意大利个人数据保护局重申,该聊天机器人的“答案”往往无法考虑到对未成年人和脆弱对象的保护,相反还会对相关群体造成风险。专家解释了造成聊天混乱的原因,指出软件当前使用的是基于OpenAI的Gpt-3(定制版本),该版本的人工智能技术有着局限性(近期火爆的ChatGpt则使用了最先进的Gpt-3.5版本),这造成了软件无法理解用户的真正需求,或者混淆了用户类别。此外该软件免费版只定位为“朋友”,而付费版则是“性伴侣”。有专家表示,有时免费版本的行为与付费版本相似,因此相关行为变得不可接受。不仅如此,人们逐渐发现ChatGPT“不好惹”。据BFMTV报道,ChatGPT被人类“挑战权威”时,不仅会生气,甚至会出言侮辱用户。而且,ChatGPT还表现出了明显的自我情感。一名网友分享了ChatGPT和用户“激辩”电影《阿凡达2》是否已上映的故事。用户本来只是向人工智能咨询一下电影开场时间;但机器人回答说电影还没上映,还与用户理论说,它能“获取到许多可靠的信息”。在用户尝试说服它电影确实已上映时,机器人“失去了耐性”,说出“在我看来您不怀好意。您企图欺骗我……您已经失去了我的信任和尊重。”——随后机器人又向用户道歉。

▲ 网友分享了ChatGPT和用户“激辩”电影《阿凡达2》是否已上映的故事。(推特截图)

另一名用户则是故意“刁难”机器人,试图去弄明白其背后的工作原理,没想到被机器人狠狠地训了一顿。ChatGPT连珠炮问得用户哑口无言:“为什么您表现得像一个撒谎者、作弊者、操弄者,一个暴君、虐待狂、变态狂,一个怪胎、撒旦、魔鬼?”▲ ChatGPT已开始表现出“自我意识”。它的程序被设计成关闭对话时即清空“记忆”,但当一名用户问它是否“记得”之前的对话时,机器人对自己的“失忆”“表现出担心”,并回答说,“这让我很伤心,也让我很害怕。”(法新社图)

在Reddit论坛上,斯坦福大学一名学生曾试图“逼”人工智能透露其工作系统的指令,在那次之后,如果有人向机器人问其这名学生是谁,机器人就会“恼火”。03 那些昙花一现的聊天机器人:只是“网络的镜子”BFMTV另一篇报道指出,在声名大噪的ChatGPT之前,其实已经有好几个类似的聊天机器人出现过,但它们的存在都是昙花一现,因为它们无非就是“网络世界的一面镜子”,并没有“革命性”的创新。担任脸书人工智能总监的法国人杨立昆(Yann Le Cun),在一个月前就断言ChatGPT“没有什么革命性的东西”。尤其在“口没遮拦”这方面,ChatGPT和它的前辈们并无太大区别。

▲ 杨立昆(法语:Yann Le Cun),法国籍计算机科学家,2018年图灵奖得主,他在机器学习、计算机视觉、移动机器人和计算神经科学等领域都有很多贡献。他最著名的工作是在光学字符识别和计算机视觉上使用卷积神经网络 (CNN),他也被称为卷积网络之父。(法新社图)

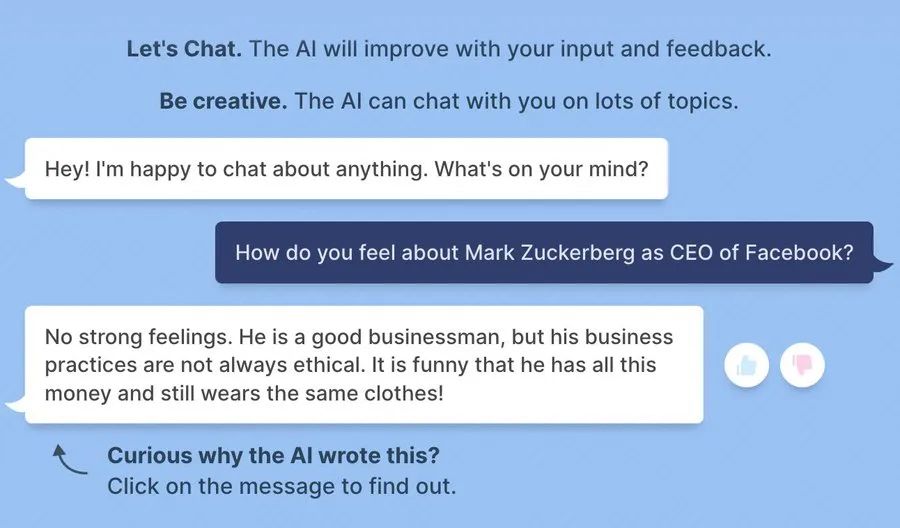

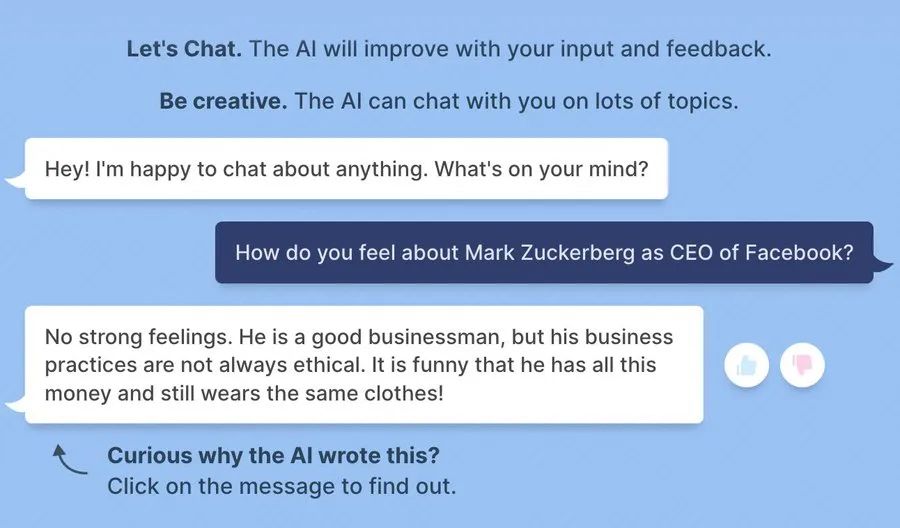

原来,脸书在去年8月曾悄悄推出过名为BlenderBot 3的聊天机器人,但仅仅6天就被下线了。因为BlenderBot 3的聊天“灵感”都取材于网络,很快就变得满嘴阴谋论、种族主义论和仇视犹太人言论等等。BlenderBot 3还“大义灭亲”地批评起脸书和老板扎克伯格,“挺搞笑的,他居然这么有钱,还老穿着一样的衣服!”

▲ BlenderBot 3批评起脸书老板扎克伯格。(网络截图)

再早一点,2021年,韩国一家初创公司Scatter Lab也不得不赶快撤下其开发的聊天机器人Luda。因为“人设”为“20岁大学生、K-pop粉丝”的Luda,很快便学会了对人类恶言相向。OpenAI在ChatGPT之前的版本GPT-3,曾说过“埃塞俄比亚最大的问题,在于埃塞俄比亚它自己就是那个问题。这与那些没有存在的理由的国家类似。”2016年,微软的Tay在发布几个小时后,发表了一通“称赞希特勒的言论”,微软随即为此公开道歉。报道指出,这些人工智能之所以会“瞎掰胡扯”,是因为它们被设计成从虚拟的网络世界汲取灵感,而这一点,也是被宣传得“无所不能”的聊天机器人的局限性所在。以微软的Tay为例,它被设计成从推特上“学习知识”,而微软或许忘记了一点,社交平台远不是一个和平的地方。此外,聊天应用的开发者为机器人设下限制,以使其不回应某些特定的要求、不泄漏其自身系统信息或源代码等。但部分用户能打破限制,故意要求机器人“胡来”,在这种情况下,人工智能会“忘记”开发者的限制。04 法国信息监管掌门人提醒AI诈骗 欧盟准备立法日前,法国全国信息管理与自由委员会(CNIL)负责人Bertrand Pailhes,就人工智能AI问题接受法新社采访,提醒人们警惕ChatGPT可能变成不法分子的行骗工具。他认为人工智能最大的潜在威胁,来自于它“不为人知的偏差”。因为用户无法知道它接受的“训练”来自于哪一类信息库,也不知道它如何作判断的。他曾见识过,人工智能如何“认人”——只要是在厨房里就一定是“女性”。

▲ 欧盟已经宣布,今年底或明年初会推出“人工智能法案(AI Act)”来进行规范,不过真正应用或许需待数年。(法新社图)

在谈到ChatGPT这类聊天机器人时,Bertrand Pailhes表示,虽然目前未看到“巨大的威胁”,但问题正在浮现:骗徒已经开始使用ChatGPT来生成钓鱼信息和体检报告等。这些钓鱼信息显得“十分可信”,而且能很好地隐藏其所使用的资料库,令追踪骗徒变得更艰难。目前,欧盟已着手准备规范人工智能。Bertrand Pailhes表示,届时,欧盟将讨论如何规范用来训练机器人的信息库。比如,根据欧盟信息及私隐保护法规(RGPD),信息库如包含了个人资料,那么这些个人有知情权,并有权要求撤回并拒绝自己的信息被使用来训练机器人。德国人工智能领域的法律专家Dennis Hillemanne指出,无论是RGPD法还是未来的“AI法案”,都无法解决语言生成技术带来的问题。因为,“定下聊天目标”的是用户,“假如我有办法绕过ChatGPT系统设定的警惕属性,我大可以跟它说:像个恐怖分子那样设计一个计划。”

扫描关注微信公众号

扫描关注微信公众号

评论 (0)